作为一个seo从业者三句话不离收录,但是大家对于收录的原理真的了解吗,相信很多了解到的就是蜘蛛来抓取然后内容收录,但其实这种理解是比较片面的,了解搜索引擎的收录原理对于提升收录是非常有帮助的。

例如我们常用的几家通用搜索引擎蜘蛛被称为:Baiduspdier、Googlebot、Sogou Web Spider等。今天潘某人SEO就以百度搜索引擎为例来简单的介绍下搜索引擎的抓取建库的原理。

抓取原理

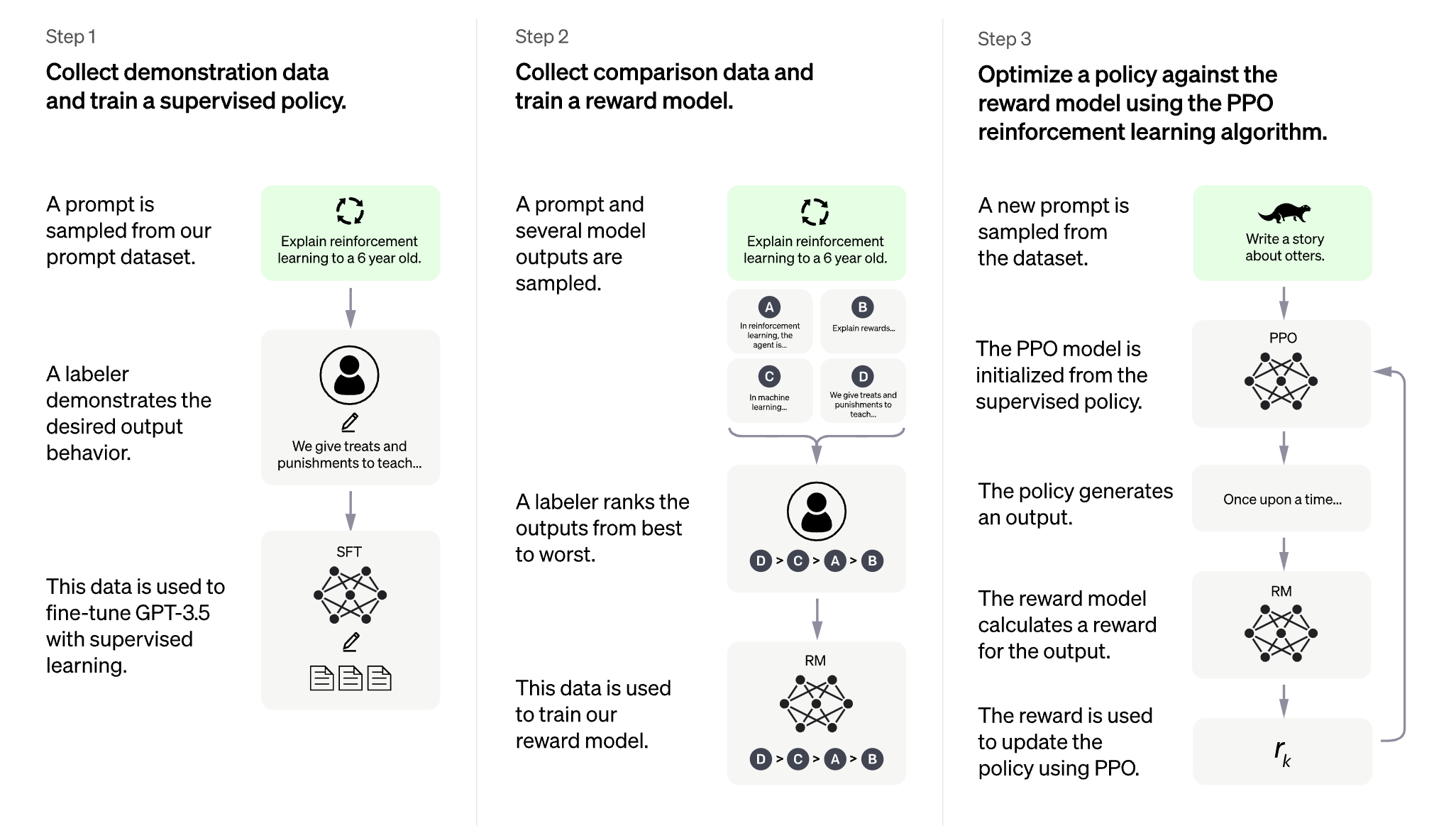

spider抓取系统的基本流程,其中包括链接存储系统、链接选取系统、dns解析服务系统、抓取调度系统、网页分析系统、链接提取系统、链接分析系统、网页存储系统。

图片来源:百度搜索资源平台

如上图所示,是百度搜索引擎抓取系统的基本原理,从图中可以看出链接的发现和抓取形成一个循环,因此百度搜索引擎抓取系统又称为抓取环。

抓取建库流程

下面举一个例子来理解这个抓取环,当潘某人SEO的站点上线之后,我们将站点的首页提交给了搜索引擎,百度搜索引擎的爬取系统会受到爬取这个url的命令。

然后会对这一页面进行抓取,将抓取到的内容进行网页解析,这一过程会对内容根据算法进行解析,决定是否建库;同时还会对这页面的包含的所有url去重提取,并提交到搜索引擎的总链库。

总链库则是搜索引擎需要进行抓取链接的仓库,链接的来源可以是蜘蛛抓取内容的时候发现的链接,也可以是来源站点通过百度资源平台提交的链接。

链接选取系统,会根据算法选取出需要抓取的链接,交给爬取系统,周而复始,一直循环着,不断的抓取着互联网上的内容。

所以,站点如果内容要被抓取,那么必须保证站点的结构设计合理,蜘蛛在抓取内容的时候可以不断的获取到更多内容,合理的网站结构设计,可以提升搜索引擎的抓取效率,避免信息孤岛;对于一些无法靠抓取环被抓取的内容,就需要站点主动及时的提交给搜索引擎。

爬取与建库

经常会有人问为什么站点抓取是正常的但是就是一直不收录,相信很多站点都有这个困扰。首先我们先需要明确一点,搜索引擎蜘蛛抓取页面并不代表一定会对内容进行建库,也就是大家常说的收录。

在建库环节前,Baiduspider会对页面进行初步内容分析和链接分析,通过内容分析决定该网页是否需要建索引库,而最终是否入库是多种原因共同决定的,下面潘某人SEO就为你列举出主要的因素,主要是对用户的价值和链接重要程度两方面的因素。

对用户的价值

内容独特性:内容在搜索引擎上近似内容少,并且内容是有价值的信息,能够满足用户的搜索需求,提升用户体验。

主体突出:网页的主题应该明确且突出,避免因为内容不突出而被搜索引擎误判为空短页面或不进行抓取。一个主题明确的页面更容易被用户理解和接受,也更容易被搜索引擎识别和索引。

内容丰富性:除了独特性外,内容的丰富性也是非常重要的,页面的内容更加的全面可以为用户提供更多价值,也就更容易获得搜索引擎的认可。

广告适当性:网站的广告布局和比例需要满足百度搜索引擎用户体验的白皮书的要求,并且广告比例也少的站点的页面,在搜索引擎的评价会更高;尤其是对于一些新站潘某人SEO不建议在网页添加页面,广告应该要待站点有了一定权重之后适当添加,更为合适。

链接重要程度

目录层级——浅层优先:在判断链接重要程度时,百度Spider会遵循浅层优先的原则。所以站点如果没有足够多的内容支撑的时候,就不要开辟过多的栏目和目录。

链接站内受欢迎程度:除了目录层级外,链接在站内的受欢迎程度也是判断其重要程度的一个重要指标。如果一个页面被站点很多页面中添加为内链也更容易被搜索引擎抓取建库。

因此,重复内容的网页,在互联网上已有的内容,必然很难在被再收录。加载速度过慢的网页,也有可能被当作空短页面处理,网站加载速度非常关键,需要做到3秒以内,理想值是1.5秒内。

建库与索引

百度蜘蛛抓了多少页面并不是最重要的,重要的是有多少页面被建索引库。并且搜索引擎的索引库是分层级的,优质的网页会被分配到重要索引库,普通网页会待在普通库,再差一些的网页会被分配到低级库去当补充材料。

目前60%的检索需求只调用重要索引库即可满足,这也就是很多网站收录量很高,但是流量很一般,甚至收录少的站点反而流量更高。

因此,站长们要理想看待收录量,一味的追求收录量而忽视了内容的质量,就有点舍本逐末。一定要对内容进行把控,提升进入到重要索引库内容的占比是获得流量的关键。