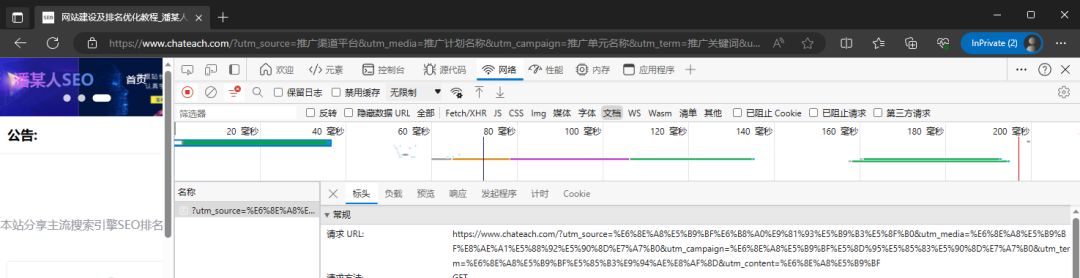

作为一个合格的SEO不仅仅是一个内容优化的高手,技术层面也是需要一两把刷子的。就比如如何分别真假搜索引擎蜘蛛就是一个比较重要也是比较实用的技能。相信大家都会去管不住网站的抓取频次,但是大多数人还是只是从站长后台去看给到的一个抓取频次。但是其实这个数据不是很稳定,而且这个工具经常出问题,对于抓取频次比较的网站,可能都看不到这一个模块的数据,并且对于搜索引擎抓取了哪些页面这是这个工具无法看到的。

因此,对于日常的SEO优化来说学会如何的通过网站日志去查看日志,对于网站日志的分析还是比较复杂,之后再去具体的探讨。今天主要是讲真假蜘蛛ip的识别方法,不管是搜索引擎的蜘蛛,还是假蜘蛛,其实都是网络爬虫。原理上是一样的,只是用途不一样,我们把冒充搜索引的蜘蛛称为假蜘蛛。

为什么有假蜘蛛

这类假蜘蛛的目的,主要就是为了爬取网站的内容,然后为己所用。简单的说就是抄袭转载网页内容,只是把传统的手动方式改成了程序的自动处理。对于这类假蜘蛛它会把自己爬虫的user-agent伪装成和百度一样的,为了就是不被站长们发现屏蔽,达到长期的潜伏着爬取内容。

对于SEO来说内容的稀缺性很重要,如果自己的原创内容被多处抄袭转载,更甚至抄袭者比你先收录,那么对于自己的站点优化是非常的不利的。

如何识别真假蜘蛛

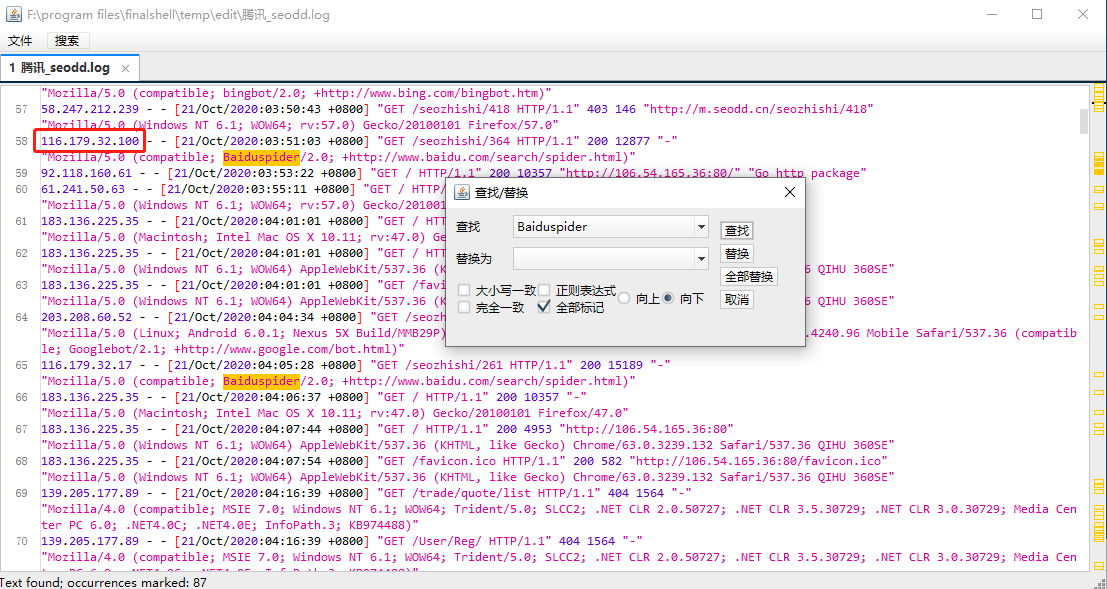

其实发现真假蜘蛛很简单,首先我们需要了解各大搜索引擎蜘蛛名称,比如百度蜘蛛为“baiduspider”。我们就在当天的网站日志中搜索这个关键字,找出有多少条结果。然后对比站长工具中的抓取频次,如果两者的数据差异很大,这个时候我们就需要进一步的去排查了,抓取次数相差很大绝对是由假蜘蛛。

然后我们就要去锁定哪些ip是有异常的,一般来说搜索引擎的蜘蛛不会集中在一个时间段去抓取内容,因此为了更好的及时发展新内容,抓取的时间段是会比较分散的。如果某一个ip会集中的大量抓取页面,那么我们就要重点排查这个IP了。

这种方法操作起来还是比较复杂的,对于日志比较大的网站就不会合适了。更加科学的方法是,写一个程序列出以各个搜索引擎user-agent名称请求的ip,同时需要取到每个ip的访问次数,这样一方面我们可以结合搜索引擎公布的ip段,以及我们能自己排查确认的搜索引擎ip,一排除就可以非常容易的找出有问题的IP。

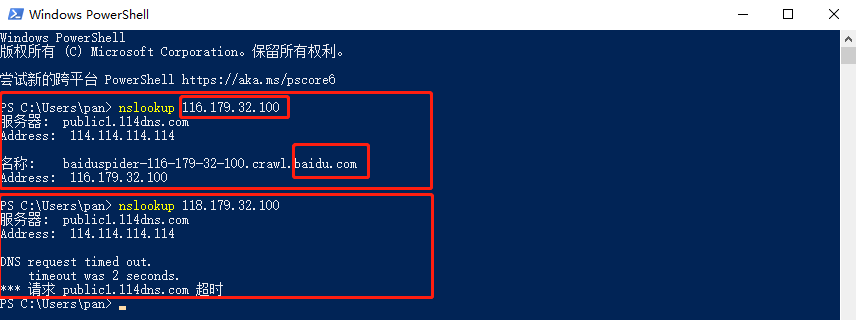

最后一步就是屏蔽有问题的ip,毕竟于搜索引擎抓取有关,这类ip的封禁我们需要更加的严谨,对于ip需要做一个检验,这个也是非常简单的,使用电脑的cmd中的nslookup命令就可以实现,真假蜘蛛ip的鉴别。

日志大家一定记得按日分割,这边随便拿一个百度蜘蛛的ip做一个演示

习惯用powershell了,用cmd也是一样的没区别的,可以看出如果ip是真的属于搜索引的ip,通过nslookup命令是可以反查到ip对应解析到的域名,这个是绝对可靠的,只要解析的域名是对应搜索引擎的,那就没有问题,如果是假蜘蛛,那么要么是出现解析的域名不对,或这个就是直接超时。

今天讲到的这个需要完全的自动化实现还是存在一定的技术难度的,高度依赖于对日志文件进行操作ip的分离,有兴趣的小伙伴可以公众号,后续会出教程。