对于搜索引擎来说每天需要承载着数以万计的url的抓取任务, 正是因为日复一日的数据抓取,我们才能搜索到我们需要讯息。同样的对于网站来说则是被抓取的量显得非常的重要,抓取的速度和量决定了网站的内容是不是能够及时的推送给用户。

对于搜索引的抓取流程大致是:抓取网址->内容质量评估->索引库过滤->网页包含(显示在搜索结果中)。对于大多数网站内容质量比较差,比如采集拼凑、转载、无意义内容,就会被放入低质量索引库,简单点说就是这类链接即使收录了,也是基本没有机会参与排名的。

长期以往如果内容的质量都是比较差,那么最终抓取量就是不断的降低知道消失,不在对网站进行抓取。所以网站的抓取量一定程度上反应了搜索引擎对于站点内容的认可程度。

影响抓取频率的因素:

①网站内容:比较重要的一点就是上面说的内容的质量,网站内容的质量决定了是否可以稳定的获取抓取。

②网站结构:对于搜索引擎除了链接推送的时候有针对的抓取特定的链接,对于日常的爬取的时候,依然是从网站的首页进行抓取。所以一个设计合理的首页和网站结构是非常的重要的。

网站首页最好采用聚合首页的形式,可以承载网站各个模块的入口。同时首页需要保持一个活跃的更新状态,可以有利于搜索引擎的抓取。

网站的结构则需要层次分明,并且随着搜索引擎从浅到深的抓取,页面内容应该是越来越丰富。同时的层级结构需要清楚的反应在URL的结构上,网站结构要做到简单明了清晰,不要去做过于复杂的结构,会造成抓取效率低下。

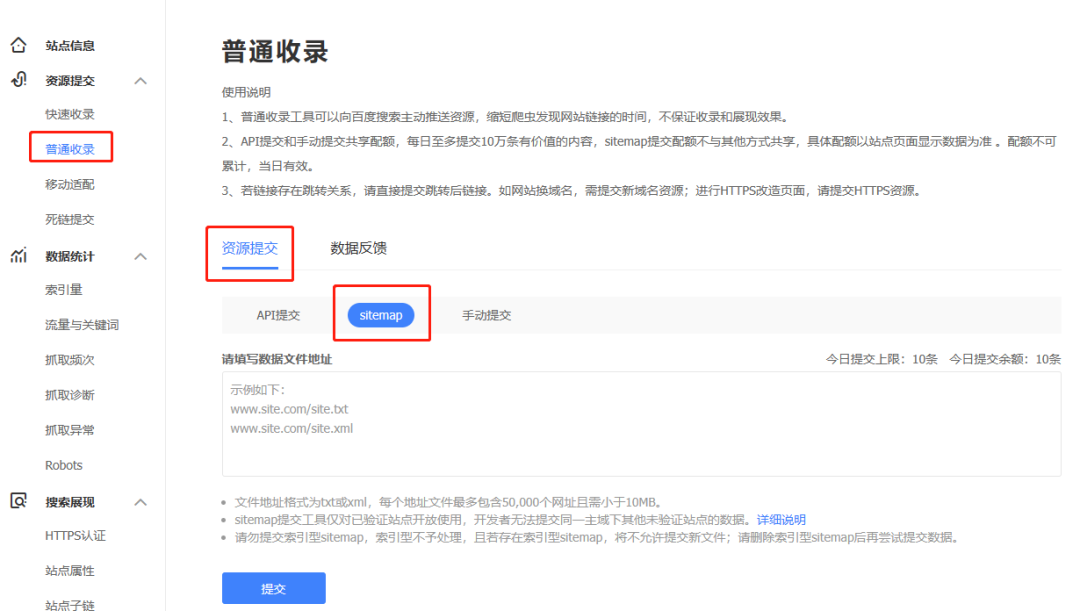

③链接提交:网站的内容更新,一定需要去及时的向搜索引擎推送链接,可以加快页面的发现速度。同时可以保证自己内容的安全性,对于搜索引擎鉴定内容的原创者是谁,主要还是根据哪个站点的索引建立更早。建议的链接推送方式,内容更新之后立刻进行主动推送方式进行推送,经过实践这种方式是最快的;同时结合自动推送方式和sitemap方式进行补充。

④网站性能:绝对搜索引擎抓取频次大小的还要一个比较重要的因素就是抓取压力。也就是服务器的带宽以及相应速度,我们需要把抓取时间控制在1500毫秒以下,否则搜索引擎就会为了保证站点的正常访问降低对于站点抓取频次。

⑤抓取诊断:比如百度站长工具中的抓取异常模块就是我们需要关注的,我们可以看相关的异常状态码,可以清楚的知道抓取时遇到的访问问题。通过此处我们可以发现网站是否存在死链,以及页面访问是否稳定正常,出现异常需要及时的处理。

⑥死链处理:当网站出现死链的时候我们一定要做到在搜索引擎抓取到之前就进行死链提交,一方面抓取到大量的死链会影响用户体验导致站点的评级降低。另外一个站点每日的抓取数量是有限的死链也会浪费站点的抓取数量。

⑦robots:合理的设置robots.txt文件可以防止隐私信息被抓取到,同时可以很大程度提供抓取的有效性,屏蔽了无效页面的抓取。 很多站点会去屏蔽js和CSS文件的抓取,建议不要这个做如果这些js和css文件参与了页面效果的渲染,那么不应该去屏蔽。我们只去屏蔽不需要被抓取的页面目录就可以了。