今天我们来了解下什么是蜘蛛黑洞,黑洞大家应该有一定的了解,属于一种高质量高引力天体,包括光任何的物体都无法逃逸。蜘蛛黑洞既是蜘蛛进入之后无法再出来,对正常的抓取工作产生负面影响。

造成蜘蛛黑洞的原因

有些站点含有大量的重复页面,常见的如站点的内容雷同,但具体参数不同的动态URL ;就会导致蜘蛛抓取大量相似或者相同的内容,导致有限的抓取频次被消耗殆尽,一定程度上影响了有价值页面的及时收录。

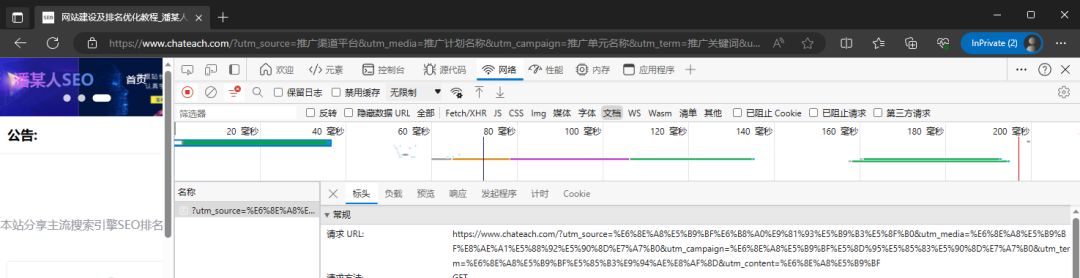

重复内容其实很难避免,比如有的站点内容页面有筛选功能,通过不同的条件去筛选显示对应的内容,常用的技术有点就是根据条件通过ajax查询反馈结果到当前页面,就会导致不同的查询结果,出现同一个链接带不同参数的url出现。最终就导致展现有大量的带参数的重复url被收录。不仅仅会影响搜索引擎的抓取,站点出现大量的相似内容也会对网站的评级产生影响。

屏蔽动态链接

对于这类情况处理还是很简单的,就是屏蔽所有动态链接的抓取,通过robots.txt文件规则来实现。在robots文件中添加Disallow: /*?* ,即禁止搜索引擎访问网站中所有的动态页面。这样就可以简单高效的屏蔽了低质量页面的抓取,有效的避免了蜘蛛黑洞的出现。

但是有的时候某些站点的动态页面是有价值的,是需要被收录的,直接屏蔽所有动态页面的抓取是不合理的;可以在Disallow: /*?* 的下一行添加允许抓取的动态链接,比如站点"/seodd"目录下的动态链接允许抓取,那么就是添加一行 allow: /seodd/*?* 。如果需要放通的比需要屏蔽的更多,就可以一个个目录屏蔽,而不是屏蔽所有目录再去放通某个目录。